大家好,我是一名 ComfyUI 狂热爱好者。今天要带大家体验一个超硬核、超自由的视频生成玩法——使用 Wan2.2-Fun-Inp 和 Fun-Control 模型,在 ComfyUI 中实现“起始帧-结束帧”可控生成视频!

别再说 AI 视频生成只能看天吃饭了,现在我们终于有了“导演级控制感”!

🧠 什么是 Wan2.2-Fun-Inp / Fun-Control?

这两个模型都出自阿里巴巴 PAI 团队,开放、免费、支持商业使用(Apache 2.0 License),最关键的是,它们提供了视频生成界前所未有的“可控性”。

🔹 Wan2.2-Fun-Inp:帧控之王

-

支持输入起始帧 + 结束帧,AI 负责补全中间过渡动画

-

可生成 电影级质量的视频

-

支持多分辨率(512×512 到 1024×1024)

-

有 Lightning LoRA 加速版本(更快但略损动态)

🔸 Wan2.2-Fun-Control:控制狂魔

-

多模态条件支持:Canny、OpenPose、MLSD、Depth、轨迹都能控

-

输入一张图 + 姿势视频,就能输出姿势跟随动画

-

提示词支持中文和英文!

两者的核心目标都是一样的:让视频生成“听话”。

⚙️ 如何在 ComfyUI 中玩转它?

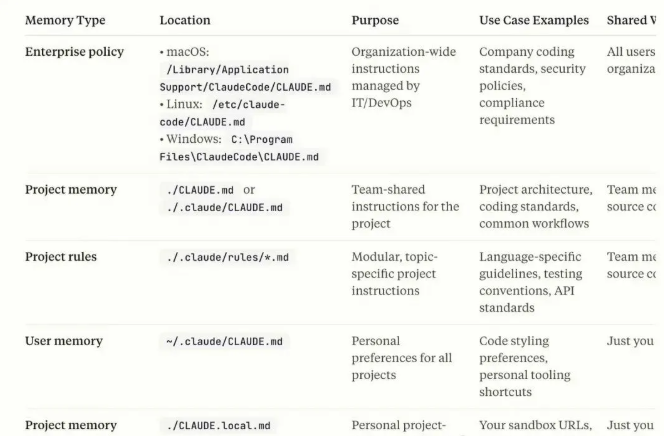

一、准备工作

你需要一台显卡内存至少 24GB的设备(测试用的是 RTX 4090D),并确保你的 ComfyUI 是 Nightly 版本。

安装模型目录结构示意:

ComfyUI/

├── models/

│ ├── diffusion_models/

│ ├── loras/

│ ├── text_encoders/

│ └── vae/

建议模型下载:

-

wan2.2_fun_inpaint_high_noise_14B_fp8_scaled.safetensors -

wan2.2_i2v_lightx2v_4steps_lora_v1_high_noise.safetensors -

wan_2.1_vae.safetensors -

umt5_xxl_fp8_e4m3fn_scaled.safetensors

https://huggingface.co/alibaba-pai/Wan2.2-Fun-A14B-InP

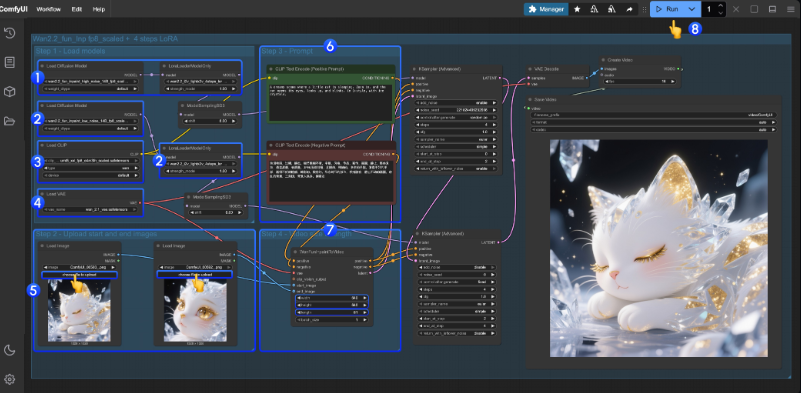

二、加载工作流

ComfyUI → Workflow > Browse Templates > Video,找到 Wan2.2 Fun Inp 或 Fun Control 模板。

如果看不到?请更新 ComfyUI 到最新版,Nightly 用户可直接享受最新节点支持。

🧪 两种视频生成方式详解

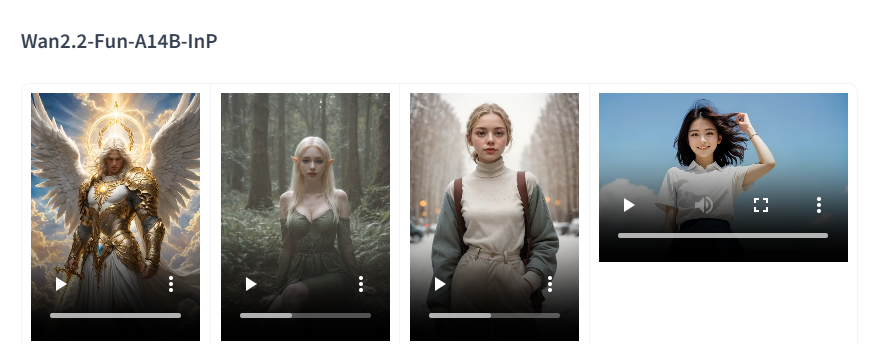

✅ 模式一:起始帧 + 结束帧 → 自动生成中间动画(Fun Inp)

你只需提供:

-

起始图

-

结束图

-

一个描述视频内容的 Prompt(支持中英)

-

帧数长度(如 81 帧)

-

输出尺寸(推荐 640×640)

核心节点配置:

|

|

|

|---|---|

|

|

wan2.2_fun_inpaint_high_noise_14B_fp8_scaled |

|

|

wan2.2_i2v_lightx2v_4steps_lora_v1_high_noise |

|

|

wan_2.1_vae.safetensors |

|

|

umt5_xxl_fp8_e4m3fn_scaled.safetensors |

工作流节点名为 WanFunInpaintToVideo,你可以设置分辨率、长度等参数后点击运行(Ctrl+Enter)。

⚠️注意:LoRA 模式虽然快,但生成的视频动态略微损失,可以按需关闭。

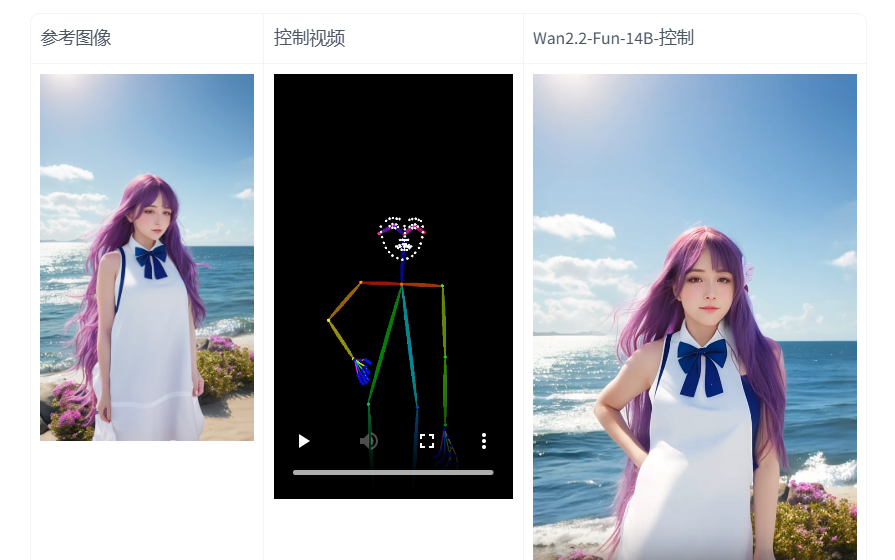

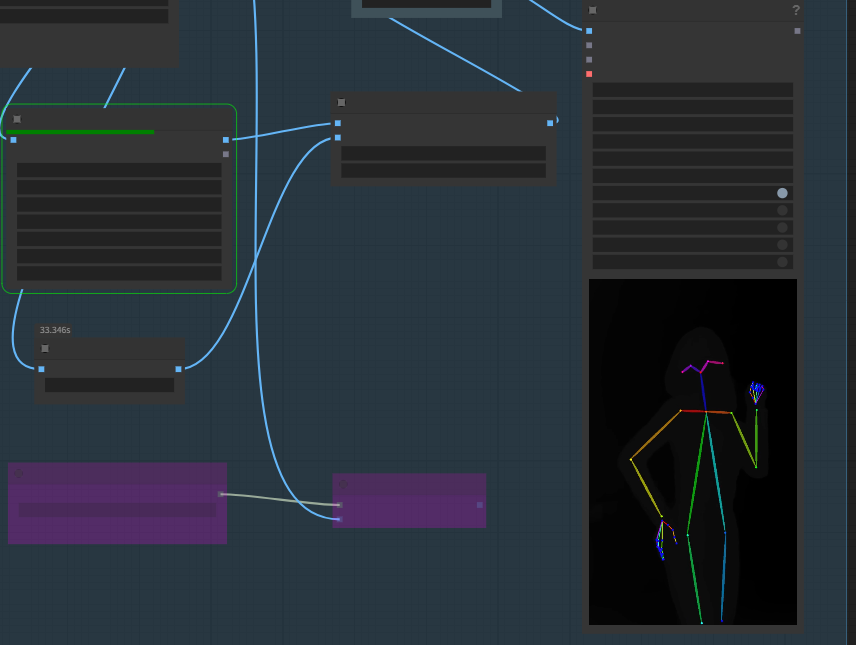

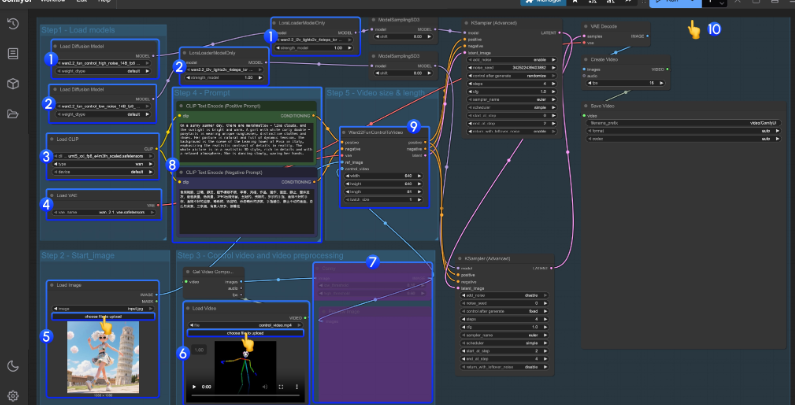

✅ 模式二:图像 + 姿势控制视频 → 姿势跟随视频(Fun Control)

-

提供一个起始图(如人物站姿)

-

上传一个姿势控制视频(如跑步姿势)

-

使用中文或英文描述生成内容

提供的控制视频素材已处理好姿势,不需要额外预处理节点,记得禁用预处理模块 Ctrl+B!

控制类支持:

-

OpenPose(推荐用于人物)

-

Canny、Depth、MLSD 等(推荐用于物体/场景变化)

工作流节点为 Wan22FunControlToVideo,你可以在里面设置分辨率(640×640)、帧数、控制参数等。

📊 性能实测(RTX4090D 24G VRAM)

|

|

|

|

|

|

|---|---|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

如果你是第一次尝试,建议先用 LoRA 版本熟悉流程。

💡 实用小技巧

-

Ctrl+B 快捷键:启用/禁用当前选中节点

-

起始帧+结束帧+Prompt 三重控制 = 精准可控短视频

-

如果要生成 5 秒视频,设置帧数为

5 x FPS(默认 FPS=16) -

使用 SD-WebUI 预处理姿势图再导入,也能实现更复杂控制

📌 总结:Wan2.2 × ComfyUI = 让 AI 视频听你导演

过去我们做 AI 视频总像“猜谜”,系统说了算。现在,Wan2.2 系列模型的加入,真正把视频生成带进了“创作者控制时代”。

不论是画面衔接的自然过渡,还是动作姿势的精确还原,都能通过这套工作流程实现——而且开源免费!

📣如果你也是一名 ComfyUI 的深度用户,这套“Fun Inp + Fun Control”组合值得你马上安排!

参考文献:https://docs.comfy.org/tutorials/video/wan/wan2-2-fun-control

相关文章