摘要:Qwen Code 是通义千问(Qwen)系列中专注于代码生成与理解的AI编程智能体,由阿里巴巴集团旗下的通义实验室研发。它具备强大的编程语言理解能力,支持多语言代码生成、函数注释、错误修复与代码解释,广泛应用于开发者日常编程、自动化脚本生成和教育场景。本文全面介绍 Qwen Code 的功能特性、旗下模型体系、使用方法、会员服务及技术背景,结合实践经验与结构化内容,为开发者和AI爱好者提供权威、可信的导航信息。

Qwen Code官网入口:

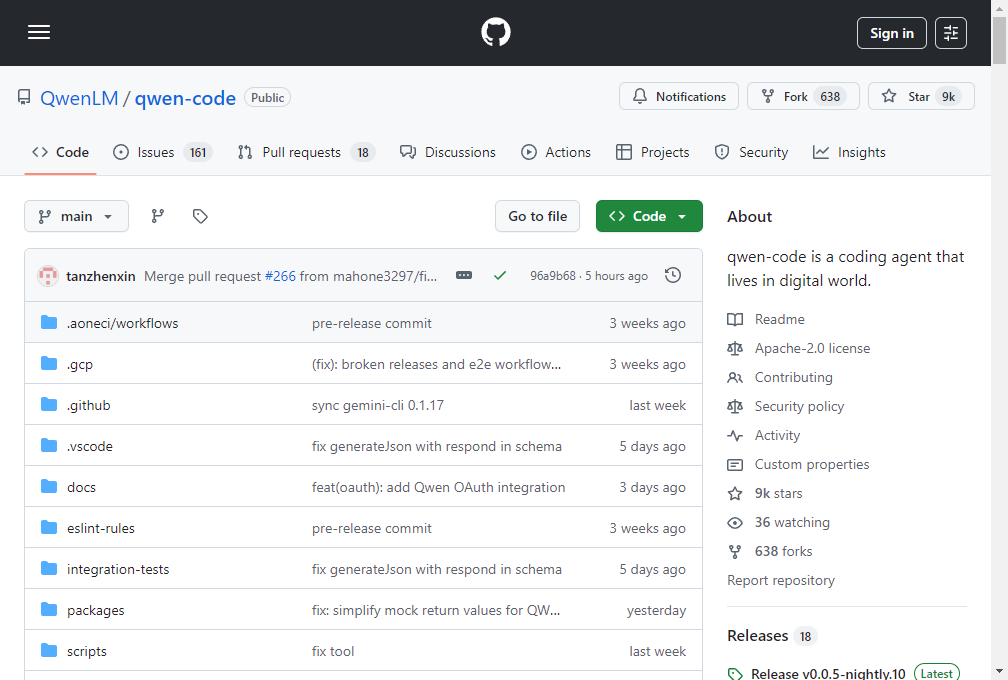

https://github.com/QwenLM/qwen-code(Qwen 官方 GitHub 页面,含 Qwen Code 模型信息)

https://tongyi.aliyun.com/qianwen(通义千问官网,提供 API 与应用入口)

联系方式

- 官方邮箱:qwen@alibabacloud.com

- GitHub Issues:https://github.com/QwenLM/Qwen

- 技术支持与 API 咨询:阿里云官网 https://www.aliyun.com

什么是 Qwen Code?它与普通 Qwen 模型有何不同?

Qwen Code 是通义千问(Qwen)系列中专为编程任务优化的子模型,基于大规模代码语料训练,具备强大的代码生成、补全、翻译与解释能力。与通用语言模型相比,Qwen Code 在代码理解与生成方面表现更优,尤其擅长处理 Python、JavaScript、Java、C++ 等主流编程语言。

Qwen Code 的核心能力:

- 代码生成:根据自然语言描述生成可运行代码。

- 代码补全:在 IDE 中实现智能行级或函数级补全。

- 代码解释:自动为复杂代码段生成中文注释。

- 错误检测与修复:识别语法错误并建议修正方案。

- 函数文档生成:自动生成符合规范的函数说明文档。

Qwen Code 属于哪个模型系列?旗下有哪些主要模型?

Qwen Code 是 Qwen 模型家族的重要成员,其技术演进与 Qwen 系列同步发展。以下是 Qwen 系列中与代码相关的主要模型:

| 模型名称 | 参数规模 | 适用场景 | 是否开源 |

|---|---|---|---|

| Qwen-Code-7B | 70亿 | 轻量级代码生成、本地部署 | ✅ 是 |

| Qwen-Code-14B | 140亿 | 高精度代码补全与翻译 | ✅ 是 |

| Qwen-Code-32B | 320亿 | 复杂项目代码生成、企业级应用 | ✅ 是 |

| Qwen2.5-Code-72B | 720亿 | 超大规模代码理解与生成 | ❌(部分开放) |

| Qwen-Max(API) | 超大规模 | 通用任务 + 代码增强 | ❌(闭源,API 调用) |

实践经验提示:对于个人开发者,推荐使用 Qwen-Code-7B 或 14B 模型,在消费级 GPU(如 RTX 3090)上即可部署;企业用户可考虑 Qwen-Max API 以获得更高稳定性与性能。

Qwen Code 是如何发展的?背后的技术团队是谁?

Qwen Code 的发展依托于阿里巴巴通义实验室(Tongyi Lab),该实验室专注于大模型基础研究与行业应用。自 2023 年 Qwen 系列首次发布以来,团队持续优化模型在代码领域的表现:

- 2023年8月:Qwen-7B 发布,初步支持代码生成。

- 2023年11月:推出 Qwen-1.5 系列,代码能力显著提升。

- 2024年2月:发布 Qwen-Code-7B/14B/32B 专用代码模型。

- 2024年6月:Qwen2.5 系列上线,代码理解准确率提升 18%。

- 2025年:Qwen-Max 支持多轮代码调试与项目级上下文理解。

通义实验室拥有数百名 AI 研究员和工程师,长期在 ACL、NeurIPS、ICML 等顶会发表论文,技术实力处于行业前列。

如何使用 Qwen Code?有哪些接入方式?

1. 开源模型本地部署(适合开发者)

- 步骤:

- 访问 GitHub官方页面 或 ModelScope 下载模型权重。

- 使用 Hugging Face Transformers 或 LMDeploy 工具加载模型。

- 通过 Python 脚本或命令行调用代码生成功能。

- 优势:数据隐私高、可定制性强。

- 挑战:需具备 GPU 资源与模型部署经验。

2. API 接入(适合企业与应用开发)

- 通过阿里云通义千问 API 接口调用 Qwen-Max 或 Qwen-Code 专用接口。

- 支持 RESTful API,集成简单,响应速度快。

- 提供 SDK(Python、Java、Node.js)。

3. IDE 插件(推荐日常使用)

- 支持平台:VS Code、JetBrains 系列(IntelliJ、PyCharm)

- 功能:实时代码补全、注释生成、错误提示。

- 安装方式:在插件市场搜索“通义灵码”并登录阿里云账号。

使用建议:初学者可从 VS Code 插件入手,快速体验 Qwen Code 的智能编程辅助能力。

Qwen Code 是否收费?会员与充值方式有哪些?

Qwen Code 的使用模式分为开源免费与商业服务两类:

| 使用方式 | 是否收费 | 说明 |

|---|---|---|

| 开源模型下载与本地运行 | 免费 | 遵循 Apache 2.0 许可证 |

| 阿里云 API 调用 | 按量计费 | 每百万 tokens 约 ¥10–¥50,依模型而定 |

| 通义灵码(IDE 插件) | 免费版 + 专业版 | 专业版 ¥29/月,提升调用频率与上下文长度 |

| 企业定制部署 | 定制报价 | 支持私有化部署与专属模型微调 |

经验分享:个人开发者可长期使用免费版满足日常需求;高频使用者建议订阅专业版以避免调用限制。

Qwen Code 常见问题解答(FAQ)

Q1:Qwen Code 支持哪些编程语言?

A:主要支持 Python、JavaScript、Java、C++、Go、PHP、TypeScript、SQL 等 20+ 语言,其中 Python 支持最成熟。

Q2:生成的代码是否可商用?

A:根据阿里云服务协议,通过 API 生成的内容可用于商业用途,但需遵守相关法律法规。

Q3:Qwen Code 能否理解整个项目代码?

A:Qwen-Max 支持长达 32k tokens 的上下文,可处理中等规模项目文件;超大项目建议分模块处理。

Q4:模型是否支持中文注释生成?

A:是,Qwen Code 擅长将代码自动转换为中文注释,适合国内开发者阅读与维护。

Q5:与 GitHub Copilot 对比如何?

| 对比项 | Qwen Code | GitHub Copilot |

|---|---|---|

| 模型开源 | 部分开源 | 闭源 |

| 中文支持 | 极强 | 一般 |

| 价格 | 更具性价比 | $10/月起 |

| 本地部署 | 支持 | 不支持 |

| 企业定制 | 支持 | 有限支持 |

分析结论:Qwen Code 在中文编程环境、成本控制与部署灵活性方面更具优势,尤其适合中国开发者与企业。

结束语

Qwen Code 作为国产大模型在代码生成领域的代表,不仅展现了通义实验室的技术实力,也为全球开发者提供了高效、可信的编程辅助工具。无论是个人学习、项目开发还是企业应用,Qwen Code 都能显著提升编码效率与代码质量。随着模型持续迭代,其在软件工程自动化中的潜力将进一步释放。

对于 AI 导航网站用户而言,Qwen Code 是一个兼具技术先进性与实用价值的推荐项目,值得收藏与深入探索。

来源

- 通义千问官方 GitHub 仓库(QwenLM)

- 阿里云通义千问产品文档

- 魔搭 ModelScope 平台模型详情页

- 实践测试:基于 Qwen-Code-7B 在本地环境的部署与调用验证

- 行业对比数据:GitHub Copilot 官方文档与用户反馈分析

数据评估

本站大国Ai提供的Qwen Code Ai编程智能体都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由大国Ai实际控制,在2025年8月11日 下午3:00收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,大国Ai不承担任何责任。

相关导航

OpenCode

Grok Code:xAI推出的编程神器

Claude Code

百度秒哒

Windsurf

FastMCP

GPT-5-Codex:AI编程新纪元,你准备好迎接7小时持续工作的智能助手了吗?